AIが、データセンター内およびデータセンター間のネットワークに及ぼす影響はどのようなものでしょうか。AIの可能性を最大限に引き出す高パフォーマンス・ネットワークの重要性について、Cienaのブライアン・ラヴァージュ(Brian Lavallée)が解説します。

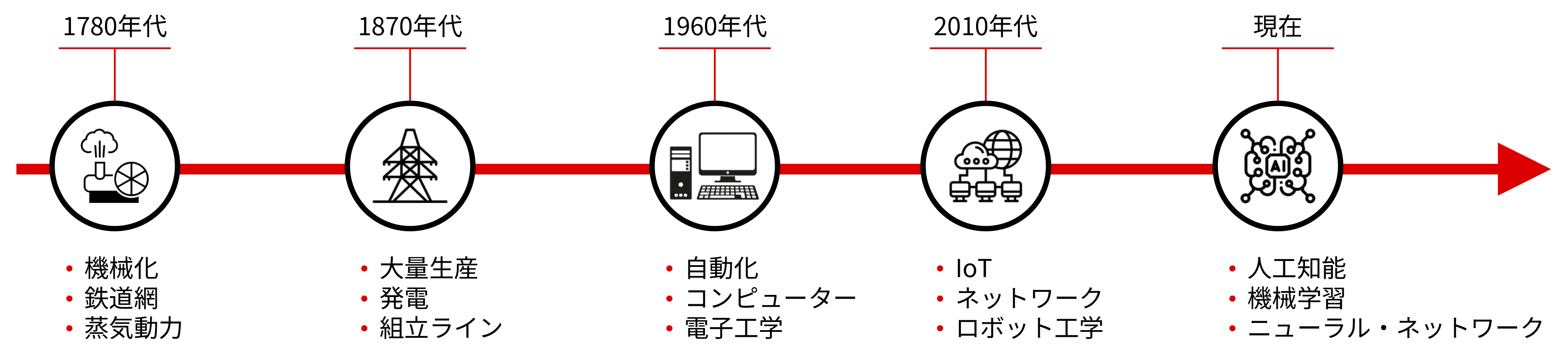

人工知能(AI)関連のブームは過熱していますが、AIの実効性や、すでに多様な産業を大きく変革していること、また、以前には想像できなかったレベルまでイノベーションと効率性を高めていることについては、議論されていません。しかしながら、蒸気エンジン、電気、インターネットのような画期的な技術の導入時がそうであったように、AIにも固有の課題と機会があります。

図1:新技術の転換点である人工知能(AI)

AIインフラの課題は、消費電力の急増と長期的なサステナビリティーに対応しながら、費用対効果の高い方法でストレージ、コンピューティング、ネットワーク・インフラストラクチャーを拡張することです。これらの課題をより深く理解するために、AIインフラストラクチャーをホスティングしているデータセンター内のネットワークと、より長い距離を接続しているデータセンターの外部ネットワークにAIが及ぼす影響を詳しく見ていきましょう。

人工知能のためのデータセンター間ネットワーク

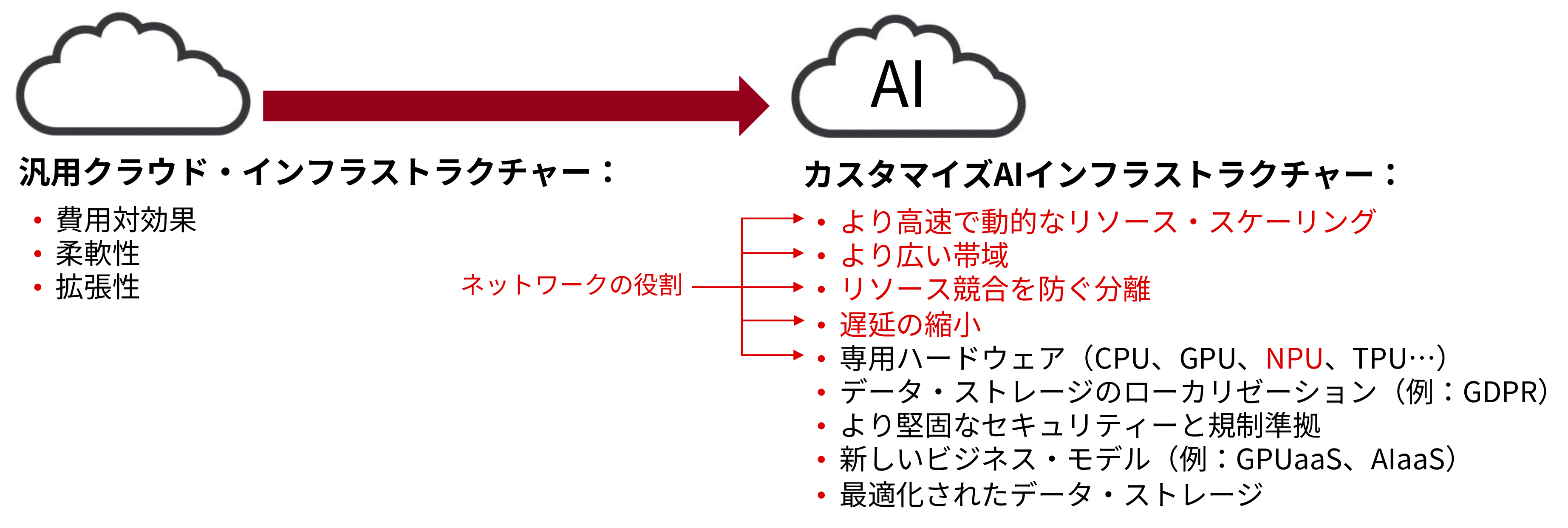

AIが誕生したのは、ユーザーがビジネスやプライベートで日常的に利用している従来のクラウド・サービスをホストしているデータセンターでした。しかし、従来のクラウド・インフラストラクチャーで大規模言語モデル(LLM)をトレーニングするといったユースケースでは、AIのストレージ、コンピューティング、ネットワーク・インフラストラクチャーの要件がすぐに複雑になりすぎて、処理負荷が増大します。LLMは、広く人気のあるChatGPTのような生成AI(GenAI)アプリケーションの基盤技術です。従来のクラウド・インフラストラクチャーの成否は、費用対効果、柔軟性、拡張性によって決まります。これらは、AIインフラストラクチャーにおいても欠くことのできない属性です。しかし、図2に示すように、AIにはネットワーク・パフォーマンスのもっと広範な新しい要件が必要です。現在、ほとんどのAIインフラストラクチャー技術は独自仕様のクローズド技術ですが、業界は、Ultra Ethernet Consortium(UEC)、 Ultra Accelerator Link(UEC)Promoter Group のような新しい標準化団体の設立を呼びかけています。より広範なテクノロジー・エコシステムを構築し、よりセキュアなベンダー・サプライチェーンを活用しながら、イノベーションを加速しようとしています。

図2:従来のクラウドとAIインフラストラクチャーの要件比較

図2:従来のクラウドとAIインフラストラクチャーの要件比較

深層学習(DL)や人工ニューラル・ネットワークを活用するLLMトレーニングなどのAI適用分野では、データセンター内にある大量のデータを広帯域、低遅延の短距離ネットワークを使用して移動します。これらのネットワークは、現在400Gb/sと800Gb/sで稼働していますが、今後は800Gb/s~1.6Tb/sで稼働するようになるでしょう。中央処理装置(CPU)やグラフィックス処理装置(GPU)のようなAIに特化したカスタマイズ・プロセッサーが開発されているのと同様に、AIインフラストラクチャーを完全に最適化するには、ネットワーク技術のイノベーションも必要です。これには、光トランシーバー、光回線スイッチ(OCS)、コパッケージド・モジュール、ネットワーク処理装置(NPU)、標準ベースUECとUALinkベース・プラットフォームなど、さまざまなネットワーク技術が含まれます。

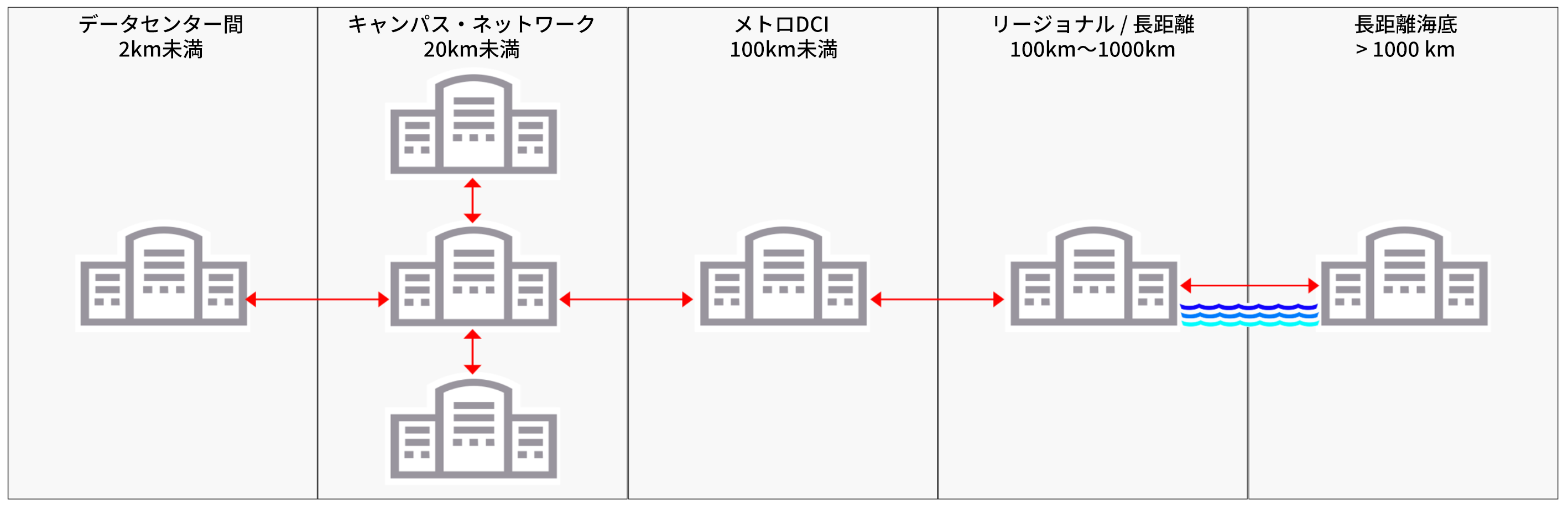

図3:データセンター内およびデータセンター間の高パフォーマンス・ネットワークによって実現されるAI

これらのネットワーク技術の進歩により、AIのパフォーマンスの課題に対応できるようになりますが、それに関連して設置スペースと消費電力も大幅に増え、データセンターの増設や相互接続の拡張につながります。必要なネットワーク・ソリューションは、データセンター内およびデータセンター間の距離に応じて異なります。

AIキャンパス・ネットワーク

AIコンピューティング・クラスターの基本要素である最新のGPUは、1つあたり1,000ワットもの電力を消費することがあります。そのため、LLMトレーニングのような目的で数十万(あるいはさらに多く)のGPUを相互接続する場合に消費電力が増えることが、データセンター事業者にとって大きな課題になっています。新しいAIインフラストラクチャーは、既存のデータセンター内の電力と設置スペースをまたたく間に消費するでしょう。これは、「キャンパス」に新しいデータセンターを構築する動きにつながります。キャンパスでは、AIアプリケーションのパフォーマンスを高めるために、データセンター間の距離を10km未満に抑えて構築し、遅延を最小限に抑えます。キャンパスは、信頼性、サステナビリティー、費用対効果が高い電力を利用可能な場所の近辺に配置する必要があります。キャンパス・データセンターは、コスト、電力、帯域、レイテンシー、距離の固有要件に合わせて最適化された光伝送技術を使用し、相互に接続されるか、距離の離れたデータセンターに接続します。

データセンター相互接続(DCI)ネットワーク

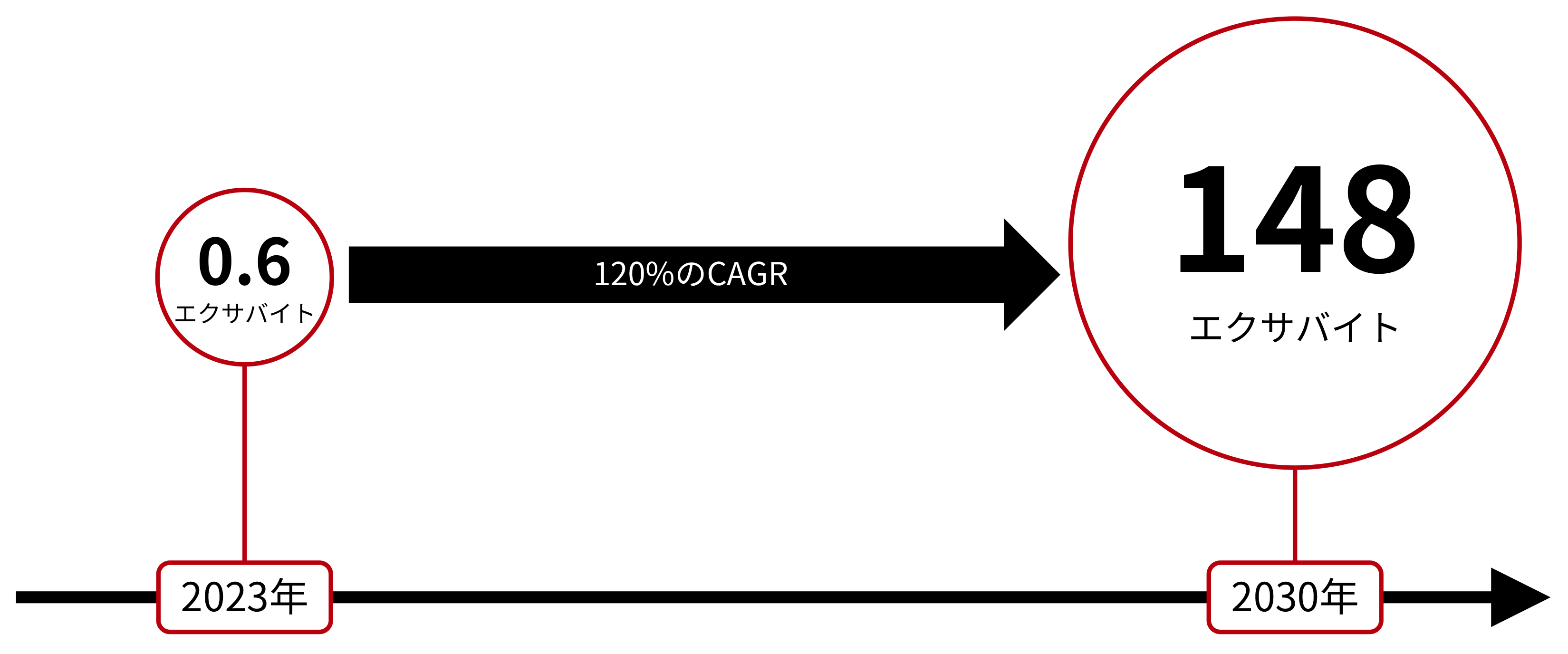

AIインフラストラクチャーは新規および既存のデータセンターにホストされているので、従来のクラウド・サービス用に現在データセンターを相互接続しているのと同様に、相互接続が必要です。これは、現在と同様な、ただし、1.6Tb/sなどのより高いレートの光伝送ソリューションを使用することで実現できます。1.6Tb/sは、CienaのWaveLogicTM 6技術が業界で初めて達成したレートです。新しいトラフィックは、どのくらいの量になるでしょうか。調査会社のOmdia社が実施した最新の分析によると、AI強化型ネットワークのトラフィックは、図4に示すように、2023年から2030年にCAGRで約120%増加すると予想されています。今後、グローバル・ネットワークを伝送されるトラフィックは大幅に増加します。

図4:2023年~2030年のAI強化型ネットワークの毎月のトラフィック成長予測(出典:Omdia)

企業の場合、AIにより、経済性、社内のAI専門家の不足に加え、消費電力と設置スペースの制限の問題に起因し、データとアプリケーションをクラウドに移行する必要性が高まります。クラウド・プロバイダーは、AI・アズ・ア・サービスまたはGPU・アズ・ア・サービス、あるいはその両方を提供するので、LLMトレーニングをクラウドで行うには、自社環境とクラウド間、およびさまざまなクラウド・インスタンス間で大量のトレーニング・データを安全に移動する必要があります。これにより、より動的でより高速な帯域による相互接続の必要性が高まり、より多くのクラウド・エクスチェンジ・インフラストラクチャーが必要になります。これは、通信事業者にとっては、新たな収益機会となります。

ネットワーク・エッジで最適化されるAIパフォーマンス

LLMのトレーニングが適切に完了すれば、コンピューティング、ストレージ、電力要件の観点からより小さなフットプリントで、最適化と「プルーニング」が行われ、実世界のAIを使用して許容可能な推論の精度を提供できます。これらの最適化されAIアルゴリズムをエッジまで拡張し、ホスティング・データを局所化することで、LLMトレーニングをホストするコアのデータセンターの負荷軽減、遅延の縮小、データプライバシーの懸案事項に関する規制の準拠を達成できます。ストレージやコンピューティングのAI資産を、AIの構築およびユーザまたはマシンによる利用が行われる場所の近辺にあるデータセンターに配置して地理的に分散することで、データ処理が高速化され、ほぼリアルタイムのAI推論を実現できます。つまり、より多くのエッジ・データセンターが相互接続されます。

消費電力とサステナビリティーの両立

AIはますます速いペースで進歩し、新しい機会と対応すべき課題を作り出しています。たとえば、深層学習(DL)や人工ニューラルネットワークを活用するAIモデルは、LLMのトレーニング・フェーズでの消費電力が大きく、膨大な量の電力を消費することで有名です。モデルが複雑になるほど、コンピューティング、ストレージ、ネットワークの機能が次々に必要になり、消費電力は増加の一途をたどります。

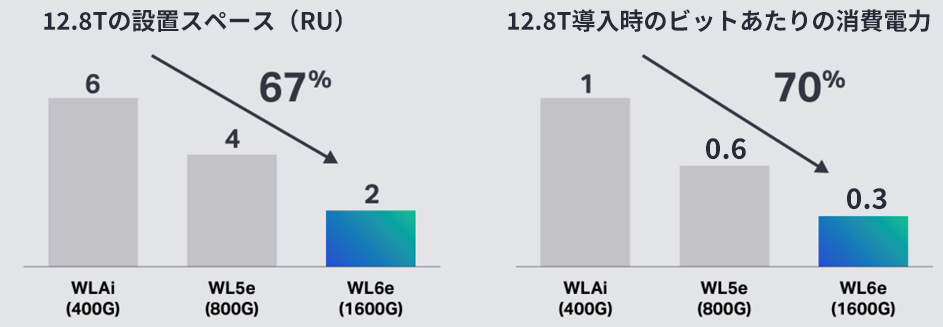

図5:ビットあたりの消費電力と設置スペースを改善し続けるCiena WaveLogicTMのイノベーション

AIインフラストラクチャーのコンピューティングおよびストレージと、それを相互接続するネットワークを比較すると、AIインフラストラクチャーの消費電力の方がはるかに大きいですが、ネットワーク帯域は関連する消費電力の増加に比例して拡張できず、サステナビリティーまたは費用対効果に欠けています。これが意味することは、ネットワーク技術は、AI機能を実現するために課せられた業界における重要な「役割を果たす」ために、ビットあたりの消費電力(および設置スペース)を継続的に削減する必要もあります。図5は、ビットあたりの消費電力と設置スペースを削減すると同時に、スペクトル効率を高め続けている、Cienaの卓越したWaveLogicTMの技術進歩を示しています。

移動できる場合にのみ価値を持つAIデータ

過熱したブームはさておき、AIは、さまざまな業界に前例のないメリットをもたらし、ビジネスとプライベートに好影響を与えます。しかし、AIの急速かつ広範な導入により、コンピューティング、ストレージ、ネットワークのビルディング・ブロックが組み込まれた基盤インフラストラクチャーに関連し、さまざまな課題が新たに浮上しています。これらの課題に効果的に対応するには、業界横断的な広範なイノベーションとコラボレーションが必要です。その理由は、AIを適切に拡張できるのは、AI LLMトレーニングをホストしているコアのデータセンター内から、AI推論をホストしているエッジのデータセンターまで、安全性、サステナビリティー、費用対効果の高い方法でデータを移動できる場合だけだからです。